Hive---安装教程

创始人

2024-05-26 00:03:27

0次

Hive安装教程

Hive属于Hadoop生态圈,所以Hive必须运行在Hadoop上

文章目录

- Hive安装教程

- 上传安装包

- 解压并且更名

- 修改 /etc/profile

- 创建hive-site.xml

- 将mysql的jar包放入Hive库中

- 开启

- 刷新配置文件

- hadoop开启

- mysql初始化

- 启动hive

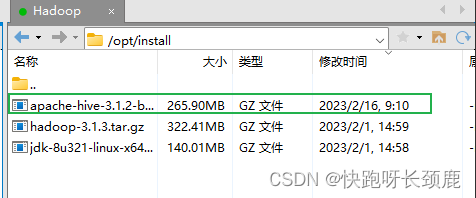

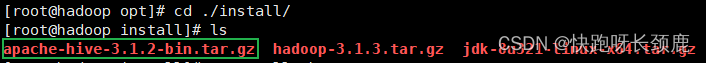

上传安装包

将安装包上传到/opt/install目录下

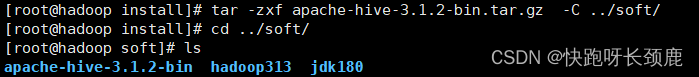

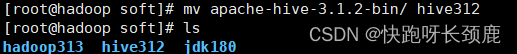

解压并且更名

[root@hadoop install]# tar -zxf apache-hive-3.1.2-bin.tar.gz -C …/soft/

[root@hadoop soft]# mv apache-hive-3.1.2-bin/ hive312

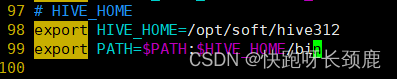

修改 /etc/profile

添加Hive环境变量

# HIVE_HOME

export HIVE_HOME=/opt/soft/hive312

export PATH=$PATH:$HIVE_HOME/bin

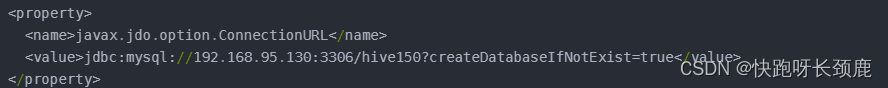

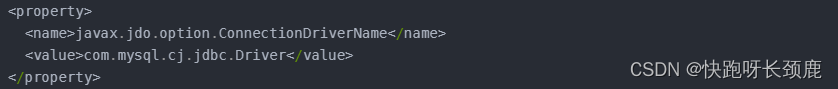

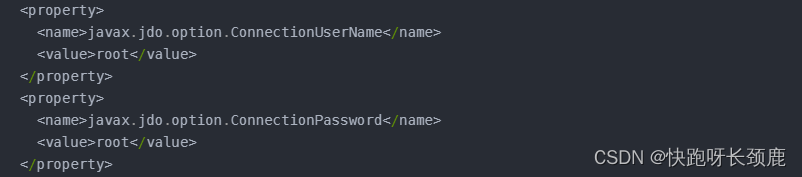

创建hive-site.xml

在/opt/soft/hive312/conf目录下创建hive-site.xml文件

[root@hadoop conf]# touch hive-site.xml

hive.metastore.warehouse.dir /opt/soft/hive312/warehouse hive.metastore.db.type mysql javax.jdo.option.ConnectionURL jdbc:mysql://192.168.95.130:3306/hive150?createDatabaseIfNotExist=true javax.jdo.option.ConnectionDriverName com.mysql.cj.jdbc.Driver javax.jdo.option.ConnectionUserName root javax.jdo.option.ConnectionPassword root hive.metastore.schema.verification false 关闭schema验证 hive.cli.print.current.db true 提示当前数据库名 hive.cli.print.header true 查询输出时带列名一起输出 注意

其中这里改成自己数据库的服务器

数据库的驱动名 这里使用的是mysql8

用户名和密码需要改成使用数据库的用户名和密码

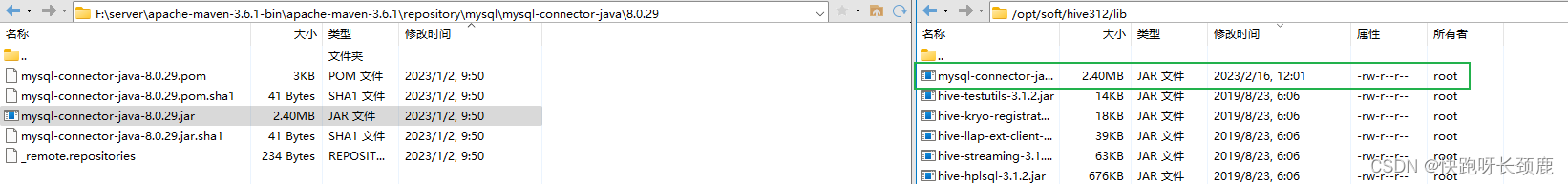

将mysql的jar包放入Hive库中

找到本机Maven工程的mysql的jar包放入/opt/soft/hive312/lib目录下

开启

刷新配置文件

[root@hadoop conf]# source /etc/profile

hadoop开启

[root@hadoop conf]# start-all.sh

mysql初始化

[root@hadoop conf]# schematool -dbType mysql -initSchema

启动hive

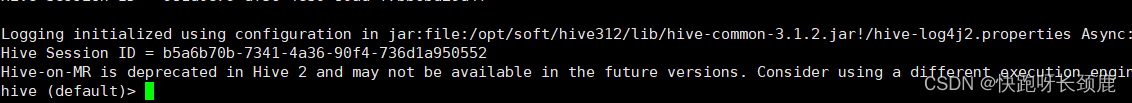

[root@hadoop conf]# hive

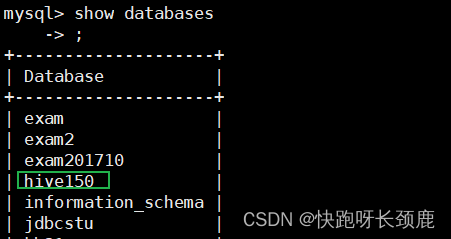

并在mysql服务器上可以看到

相关内容

热门资讯

保存时出现了1个错误,导致这篇...

当保存文章时出现错误时,可以通过以下步骤解决问题:查看错误信息:查看错误提示信息可以帮助我们了解具体...

汇川伺服电机位置控制模式参数配...

1. 基本控制参数设置 1)设置位置控制模式 2)绝对值位置线性模...

不能访问光猫的的管理页面

光猫是现代家庭宽带网络的重要组成部分,它可以提供高速稳定的网络连接。但是,有时候我们会遇到不能访问光...

不一致的条件格式

要解决不一致的条件格式问题,可以按照以下步骤进行:确定条件格式的规则:首先,需要明确条件格式的规则是...

本地主机上的图像未显示

问题描述:在本地主机上显示图像时,图像未能正常显示。解决方法:以下是一些可能的解决方法,具体取决于问...

表格列调整大小出现问题

问题描述:表格列调整大小出现问题,无法正常调整列宽。解决方法:检查表格的布局方式是否正确。确保表格使...

表格中数据未显示

当表格中的数据未显示时,可能是由于以下几个原因导致的:HTML代码问题:检查表格的HTML代码是否正...

Android|无法访问或保存...

这个问题可能是由于权限设置不正确导致的。您需要在应用程序清单文件中添加以下代码来请求适当的权限:此外...

【NI Multisim 14...

目录 序言 一、工具栏 🍊1.“标准”工具栏 🍊 2.视图工具...

银河麒麟V10SP1高级服务器...

银河麒麟高级服务器操作系统简介: 银河麒麟高级服务器操作系统V10是针对企业级关键业务...