Lasso回归理论及代码实现

创始人

2024-05-29 16:56:16

0次

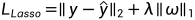

Lasso回归的模型可以写作

与一般线性回归相比, Lasso回归加入了回归项 系数

系数 的一范数, 这样做是为了防止线性回归过程发生的过拟合现象. 直观点看, 其将

的一范数, 这样做是为了防止线性回归过程发生的过拟合现象. 直观点看, 其将 的分量限制在了一个以圆点为中心以

的分量限制在了一个以圆点为中心以 为边的正方形内. 与岭回归相比, 该模型得到的系数矩阵更为稀疏.

为边的正方形内. 与岭回归相比, 该模型得到的系数矩阵更为稀疏.

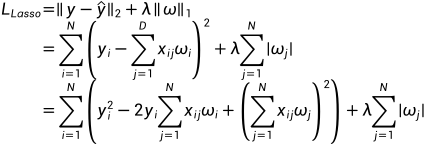

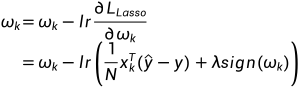

由于函数 在0点不可导, 因而Lasso回归无法通过简单的求梯度求解其结果. 本文仅整理了坐标下降法对该模型的求解过程. 也就是对

在0点不可导, 因而Lasso回归无法通过简单的求梯度求解其结果. 本文仅整理了坐标下降法对该模型的求解过程. 也就是对 的每个分量

的每个分量 采取梯度下降的方式, 使得其对每个分量

采取梯度下降的方式, 使得其对每个分量 的分量趋近于0. 首先将Lasso回归的模型重写成分量形式:

的分量趋近于0. 首先将Lasso回归的模型重写成分量形式:

对分量 求偏导可得

求偏导可得

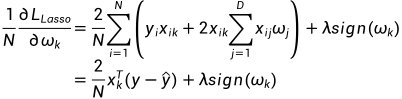

这里对于取 我的理解是在对每个分量求偏导, 暂时没找到令我信服的解释. 因而有

我的理解是在对每个分量求偏导, 暂时没找到令我信服的解释. 因而有 的表达式为

的表达式为

其中 表示学习率.

表示学习率.

由此, 可得其代码(此代码只是为了更好的了解其求解过程)

import copy

import numpy as np

# 自动生成求解数据

from sklearn.datasets import make_regressiondef lasso_recurrence(x_train, y_train, lam, lr, epochs):xmat = np.mat(x_train)ymat = np.mat(y_train).Tn, m = x_train.shapeomega = np.ones([m, 1])# 外层迭代迭代总搜索次数for i in range(epochs):# preomega表示上次搜索的omegapre_omega = copy.copy(omega)for j in range(m):# 内层迭代迭代每个维度j的搜索次数for k in range(epochs):yhat = xmat * omegatemp = xmat[:, j].T * (yhat - ymat) / n + lam * np.sign(omega[j])omega[j] = omega[j] - temp * lr# 若该omega的第j个维度已经足够接近0则终止内层迭代if np.abs(omega[j]) < 1e-3:break# 若两次迭代的omega的差别小于1e-3则终止外层迭代diffomega = np.array(list(map(lambda x: abs(x) < 1e-3, pre_omega - omega)))if diffomega.all() < 1e-3:breakreturn omegaif __name__ == '__main__':X, y = make_regression(200, 5, noise=1)print(lasso_recurrence(X, y, 0.1, 0.5, 1000))同样的可以通过调用sklearn.liner_model中的Lasso对其进行实现, 具体代码如下

from sklearn.datasets import make_regression

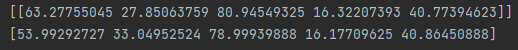

from sklearn.linear_model import Lassoif __name__ == '__main__':X, y = make_regression(200, 5, noise=1)model = Lasso(alpha=0.1, max_iter=1000)model.fit(X, y)print(model.coef_)比较两个方式的结果有

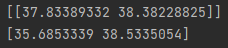

维度较高的情况下可能差异较大, 当数据维度降低时有

如此完成对Lasso回归的整理. 本文参考b站Lasso回归的讲解

回归分析-Lasso回归

上一篇:设计模式-第10章(建造者模式)

下一篇:网络协议丨从物理层到MAC层

相关内容

热门资讯

保存时出现了1个错误,导致这篇...

当保存文章时出现错误时,可以通过以下步骤解决问题:查看错误信息:查看错误提示信息可以帮助我们了解具体...

汇川伺服电机位置控制模式参数配...

1. 基本控制参数设置 1)设置位置控制模式 2)绝对值位置线性模...

不能访问光猫的的管理页面

光猫是现代家庭宽带网络的重要组成部分,它可以提供高速稳定的网络连接。但是,有时候我们会遇到不能访问光...

不一致的条件格式

要解决不一致的条件格式问题,可以按照以下步骤进行:确定条件格式的规则:首先,需要明确条件格式的规则是...

本地主机上的图像未显示

问题描述:在本地主机上显示图像时,图像未能正常显示。解决方法:以下是一些可能的解决方法,具体取决于问...

表格列调整大小出现问题

问题描述:表格列调整大小出现问题,无法正常调整列宽。解决方法:检查表格的布局方式是否正确。确保表格使...

表格中数据未显示

当表格中的数据未显示时,可能是由于以下几个原因导致的:HTML代码问题:检查表格的HTML代码是否正...

Android|无法访问或保存...

这个问题可能是由于权限设置不正确导致的。您需要在应用程序清单文件中添加以下代码来请求适当的权限:此外...

【NI Multisim 14...

目录 序言 一、工具栏 🍊1.“标准”工具栏 🍊 2.视图工具...

银河麒麟V10SP1高级服务器...

银河麒麟高级服务器操作系统简介: 银河麒麟高级服务器操作系统V10是针对企业级关键业务...