大数据体系知识学习(二):WordCount案例实现及错误总结

创始人

2025-05-30 11:54:02

0次

文章目录

- 1. 当前环境

- 2. 相关信息

- 2.1 相关文件

- 2.2 相关流程

- 3. 运行代码

- 4. 运行结果

- 5. 运行错误情况

- 5.1 py4j.protocol.Py4JJavaError

- 5.2 JAVA_HOME is not set

1. 当前环境

pyspark:版本号为3.1.2

JAVA_JDK: 版本号为1.8.0_333

Hadoop: 版本号为3.3.0

2. 相关信息

2.1 相关文件

words.txt如下

hello world hello hadoop

hadoop hello world hive

hive hive hadoop

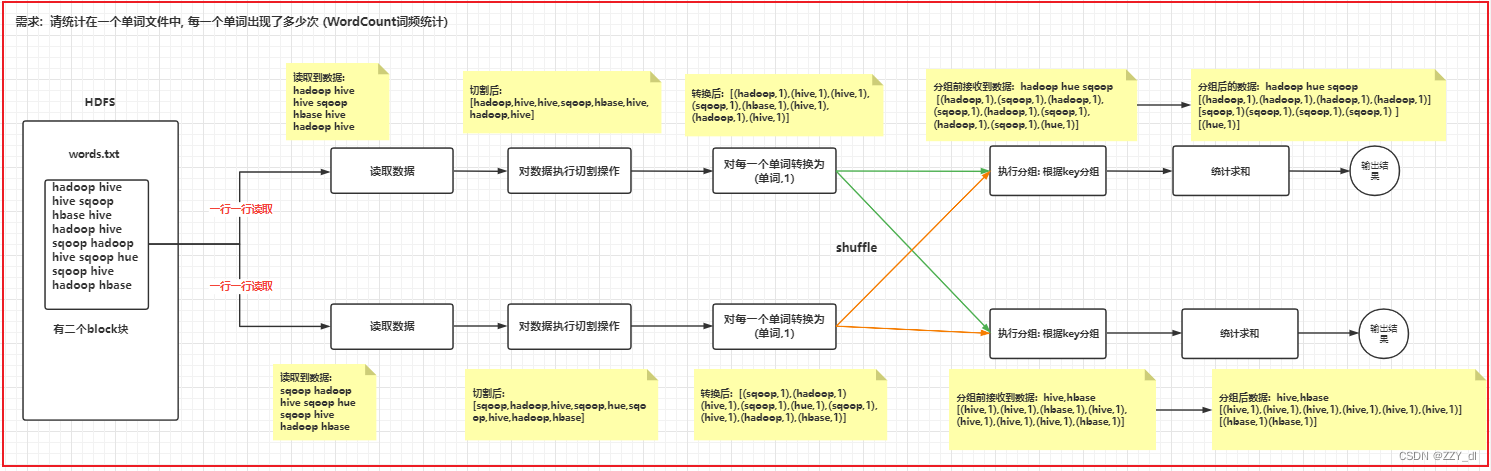

2.2 相关流程

3. 运行代码

# spark入门案例 --- WordCountfrom pyspark import SparkContext,SparkConf

import findspark

findspark.init()if __name__ == '__main__':print("spark入门案例 --- WordCount")# 1) 创建 sparkContext对象conf = SparkConf().setMaster("local[*]").setAppName("WordCount")# 自动返回 变量: ctrl +atl + vsc = SparkContext(conf=conf)# 2) 读取文件数据 file是调用本地文件rdd_init = sc.textFile("file:///F:\python\学习\Spark/file/words.txt")# 3) 对数据执行切割操作: 得到 ['hello', 'world', 'hello', 'hadoop', 'hadoop', 'hello', 'world', 'hive', 'hive', 'hive', 'hadoop']rdd_flatMap = rdd_init.flatMap(lambda line:line.split(' ')) # 一个对多个flatMap# 4) 对数据转换为 单词,1 操作# [('hello', 1), ('world', 1), ('hello', 1), ('hadoop', 1), ('hadoop', 1), ('hello', 1), ('world', 1), ('hive', 1), ('hive', 1), ('hive', 1), ('hadoop', 1)]rdd_map = rdd_flatMap.map(lambda word: (word,1)) # 一个对一个 map# 5,6) 对数据执行分组操作 统计求和操作 groupByKey是指根据key完成自动分组 reduceByKey是指根据key来做聚合# 从Shuffle的角度:# groupByKey和reduceByKey都存在shuffle的操作,但是reduceByKey可以在shuffle之前对分区内相同key的数据集进行预聚合# (combine),这样会减少落盘的数据量,而groupByKey只是进行分组,不存在数据量减少的问题,reduceByKey性能比较高。# 从功能的角度:# reduceByKey其实包含分组和聚合的功能;groupByKey只能分组,不能聚合,所以在分组聚合的场合下,# 推荐使用reduceByKey,如果仅仅是分组而不需要聚合,那么还是只能使用groupByKey。rdd_res = rdd_map.reduceByKey(lambda agg, curr: agg + curr)# 7) 输出: 打印print(rdd_res.collect())# 8) 关闭 sparkContext对象sc.stop()

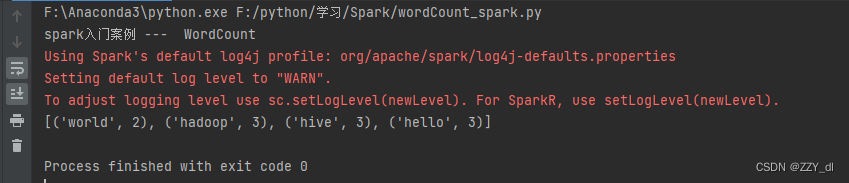

4. 运行结果

5. 运行错误情况

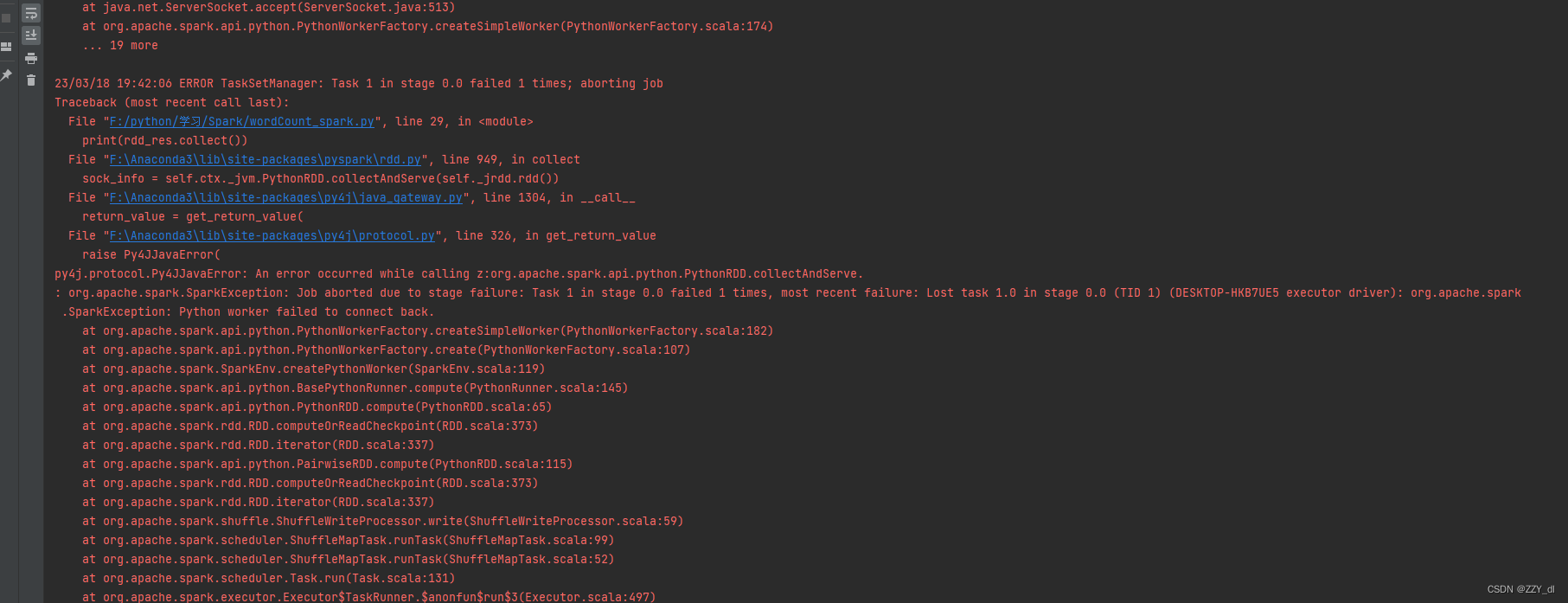

5.1 py4j.protocol.Py4JJavaError

错误截图

错误原因

因为转载时间过长找不到spark所以报错

解决办法

import findspark

findspark.init()

5.2 JAVA_HOME is not set

出现位置: 当pycharm采用SSH连接远程Python环境时, 启动执行spark程序可能报出原因: 加载不到jdk的位置

解决方案:

- 第一步: 可以在linux的 /root/.bashrc 文件中, 添加以下两行内容 (注意需要三台都添加)

export JAVA_HOME=/export/server/jdk1.8.0_241

export PYSPARK_PYTHON=/root/anaconda3/bin/python

- 第二步: 在代码中, 指定linux中spark所在目录, spark中配置文件, 即可自动加载到: 锁定远端操作环境, 避免存在多个版本环境的问题

os.environ['SPARK_HOME'] = '/export/server/spark'

os.environ["PYSPARK_PYTHON"]="/root/anaconda3/bin/python"

os.environ["PYSPARK_DRIVER_PYTHON"]="/root/anaconda3/bin/python"

相关内容

热门资讯

保存时出现了1个错误,导致这篇...

当保存文章时出现错误时,可以通过以下步骤解决问题:查看错误信息:查看错误提示信息可以帮助我们了解具体...

汇川伺服电机位置控制模式参数配...

1. 基本控制参数设置 1)设置位置控制模式 2)绝对值位置线性模...

不能访问光猫的的管理页面

光猫是现代家庭宽带网络的重要组成部分,它可以提供高速稳定的网络连接。但是,有时候我们会遇到不能访问光...

不一致的条件格式

要解决不一致的条件格式问题,可以按照以下步骤进行:确定条件格式的规则:首先,需要明确条件格式的规则是...

本地主机上的图像未显示

问题描述:在本地主机上显示图像时,图像未能正常显示。解决方法:以下是一些可能的解决方法,具体取决于问...

表格列调整大小出现问题

问题描述:表格列调整大小出现问题,无法正常调整列宽。解决方法:检查表格的布局方式是否正确。确保表格使...

表格中数据未显示

当表格中的数据未显示时,可能是由于以下几个原因导致的:HTML代码问题:检查表格的HTML代码是否正...

Android|无法访问或保存...

这个问题可能是由于权限设置不正确导致的。您需要在应用程序清单文件中添加以下代码来请求适当的权限:此外...

【NI Multisim 14...

目录 序言 一、工具栏 🍊1.“标准”工具栏 🍊 2.视图工具...

银河麒麟V10SP1高级服务器...

银河麒麟高级服务器操作系统简介: 银河麒麟高级服务器操作系统V10是针对企业级关键业务...