Flink DataStream 流处理 APi

文章目录

- Flink DataStream 流处理 APi

- 一、创建执行环境

- 1、getExecutionEnvironment

- 2、 createLocalEnvironment

- 3、createRemoteEnvironment

- 二、执行模式(Execution Mode)

- 三、触发程序执行

- 四、源算子(Source)

Flink DataStream 流处理 APi

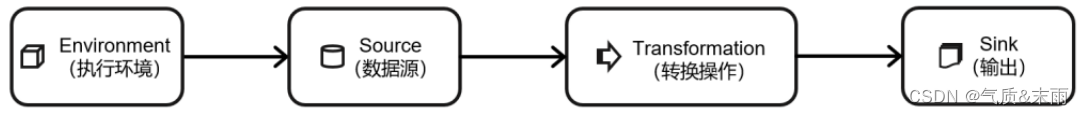

一个 Flink 程序,其实就是对 DataStream 的各种转换。具体来说,代码基本上都由以下几部分构成:

- 获取执行环境(Execution Environment)

- 读取数据源(Source)

- 定义基于数据的转换操作(Transformations)

- 定义计算结果的输出位置(Sink)

- 触发程序执行(Execute)

其中,获取环境和触发执行,都可以认为是针对执行环境的操作。

一、创建执行环境

编 写 Flink 程 序 的 第 一 步 , 就 是 创 建 执 行 环 境 。 我 们 要 获 取 的 执 行 环 境 , 是 StreamExecutionEnvironment 类的对象,这是所有 Flink 程序的基础。在代码中创建执行环境的方式,就是调用这个类的静态方法,具体有以下三种。

1、getExecutionEnvironment

最简单的方式,就是直接调用 getExecutionEnvironment 方法。它会根据当前运行的上下文直接得到正确的结果;也就是说,这个方法会根据当前运行的方式,自行决定该返回什么样的运行环境。

val env = StreamExecutionEnvironment.getExecutionEnvironment

这种“智能”的方式不需要我们额外做判断,用起来简单高效,是最常用的一种创建执行环境的方式。

2、 createLocalEnvironment

这个方法返回一个本地执行环境。可以在调用时传入一个参数,指定默认的并行度;如果不传入,则默认并行度就是本地的 CPU 核心数。

val env = StreamExecutionEnvironment.createLocalEnvironment()

3、createRemoteEnvironment

这个方法返回集群执行环境。需要在调用时指定 JobManager 的主机名和端口号,并指定要在集群中运行的 Jar 包。

val remoteEnv = StreamExecutionEnvironment.createRemoteEnvironment("host", // JobManager 主机名1234, // JobManager 进程端口号"path/to/jarFile.jar" // 提交给 JobManager 的 JAR 包 )

在获取到程序执行环境后,我们还可以对执行环境进行灵活的设置。

二、执行模式(Execution Mode)

在之前的 Flink 版本中,批处理的执行环境与流处理类似,是调用类 ExecutionEnvironment的静态方法,并返回它的对象

// 批处理环境

val env = ExecutionEnvironment.getExecutionEnvironment

// 流处理环境

val env = StreamExecutionEnvironment.getExecutionEnvironment

基于 ExecutionEnvironment 读入数据创建的数据集合,就是 DataSet;对应的调用的一整套转换方法,就是 DataSet API。

而从 1.12.0 版本起,Flink 实现了 API 上的流批统一。DataStream API 新增了一个重要特性:可以支持不同的“执行模式”(execution mode),通过简单的设置就可以让一段 Flink 程序在流处理和批处理之间切换。这样一来,DataSet API 也就没有存在的必要了。

- 流执行模式(STREAMING)

这是DataStream API最经典的模式,一般用于需要持续实时处理的无界数据流。默认情况下,程序使用的就是streaming执行模式。 - 批执行模式(BATCH)

专门用于批处理的执行模式, 这种模式下,Flink 处理作业的方式类似于 MapReduce 框架。对于不会持续计算的有界数据,我们用这种模式处理会更方便。 - 自动模式(AUTOMATIC)

在这种模式下,将由程序根据输入数据源是否有界,来自动选择执行模式。

由于 Flink 程序默认是streaming模式,我们这里重点介绍一下BATCH模式的配置。

主要有两种方式:

1、通过命令行配置:

bin/flink run -Dexecution.runtime-mode=BATCH

在提交作业时,增加 execution.runtime-mode 参数,指定值为 BATCH。

2、通过代码配置

val env = StreamExecutionEnvironment.getExecutionEnvironment

env.setRuntimeMode(RuntimeExecutionMode.BATCH)

在代码中,直接基于执行环境调用 setRuntimeMode 方法,传入 BATCH 模式。

三、触发程序执行

我们需要显式地调用执行环境的 execute()方法,来触发程序执行。execute()方法将一直等待作业完成,然后返回一个执行结果(JobExecutionResult)。

env.execute()

四、源算子(Source)

Flink 可以从各种来源获取数据,然后构建 DataStream 进行转换处理。一般将数据的输入来源称为数据源,而读取数据的算子就是源算子(Source)。所以,Source 就是我们整个处理程序的输入端。

Flink 代码中通用的添加 Source 的方式,是调用执行环境的 addSource()方法:

//通过调用 addSource()方法可以获取 DataStream 对象

val stream = env.addSource(...)

方法传入一个对象参数,需要实现 SourceFunction 接口,返回一个 DataStream。